深圳SEO屏蔽搜索引擎爬虫4大方案

浏览次数:1254 分类:SEO优化

深圳SEO做站多了就难免会出现一些无效流量,在针对这些无效流量怎么做?换句话说站内的一些需要让爬虫抓取的页面我们做深圳SEO的seoer该怎么处理?教程如下:

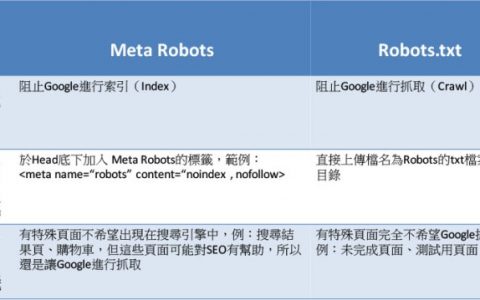

1.robots协议文件屏蔽百度或某一爬虫抓取

此类方法针对爬虫类型全站禁止抓取,可以直接屏蔽爬虫,robots书写规则:

User-agent: googlebot

Disallow: /

意思就是:禁止谷歌爬虫抓取网站,不知道书写规则的可以先访问百度官方robots协议官方文档。你若不想哪个类型的爬虫爬取那你就直接在google 替换掉。

2.robots Meta标签屏蔽百度或某一爬虫抓取

针对页面类型而言,如果不想某一个页面屏蔽百度蜘蛛或某一爬虫抓取,那么可以通过Meta标签来实现。代码如下:

<head> …

<meta name=”robots” content=”noindex,nofollow” />

</head>

这是屏蔽所有蜘蛛爬虫抓取该页面的写法,如果只屏蔽某个爬虫,可以把”robots”改为特定的爬虫名称,爬虫名称可以通过上面方法1中提及的办法获得。例如想只屏蔽微软必应的蜘蛛抓取该页,则可以写成:

<head> …

<meta name=”bingbot” content=”noindex,nofollow” />

</head>

3.通过配置文件.htaccess屏蔽百度或某一爬虫抓取

一些可恶的爬虫并不遵循robots规则,那么我们还可以通过.htaccess来屏蔽它,代码如下(以百度蜘蛛为例):

RewriteEngine on

RewriteCond %{HTTP_USER_AGENT} ^.*Baiduspider.* [NC]

RewriteRule .* – [F]

如果是Apache服务器,可以修改配置文件 httpd.conf ,这样写( /var/www/html 是根目录):

<Directory “/var/www/html”>

…

SetEnvIfNoCase User-Agent ^.*Baiduspider.* bad_bot

Order Allow,Deny

Allow from all

Deny from env=bad_bot

…

</Directory>

如果是Nginx服务器,可以修改配置文件( 默认是 nginx.conf ),这样写:

Server{

…

location / {

if ($http_user_agent !~ Baiduspider) {

return 403;

}

}

…

}

4、通过IP屏蔽百度或某一爬虫抓取

我们深圳seo还可以通过分析日志,获得爬虫的IP地址,然后从服务器防火墙屏蔽该IP,不过爬虫通常有很多IP,我们深圳seo可以屏蔽爬虫的IP段。不过此方法没有前面几个方法实用,较少人这样操作。

以上就是深圳SEO在作站过程中经常遇到的问题现在总结出来给大伙,更多深圳seo问题直接留言深圳SEO社区!

上一篇: 深圳SEO网站没流量的4大原因详解

下一篇: 深圳seo实操效果最快方法详解

深圳南山seo

深圳南山seo

售前咨询

售前咨询

您好!请登录